始まりは「近道」です。

チームが滞留タスクを解消するためにAIエージェントをワークフローに接続します。誰かが、常時の監督なしで動かせるように社内システムへのアクセス権を付与します。権限は当初は限定的で、作業に必要な最小限だけです。そしてエージェントは期待どおりに動作し、目立った副作用もなくタスクを処理します。

すると、そのまま使われ続けます。時間が経つにつれて範囲が広がり、別のシステム、さらに別のシステムへアクセスできるようになります。アクションを自動でトリガーし始め、バックグラウンドで静かに動作し、単一の責任者やレビューの起点がないまま、段階的に蓄積された権限を使うようになります。

やがて、そのエージェントは実験のようには感じられなくなり、インフラのように振る舞い始めます。今や本番システムの中で、実際の権限と実際の影響を伴って動作しています。

そして多くの組織は、それがそこにいることすら把握していません。

こうしてシャドーエージェントが定着する

AIエージェントがリスクになる要因は、どう始まるかではありません。通常の運用に、いかに容易に溶け込んでしまうかです。

多くの場合、正式なデプロイプロセスで導入されたり、従来のアプリケーションのように追跡されたりしません。多くはスクリプト、インテグレーション、埋め込み機能として入り込み、チームが新しいタスクへ適応させる過程で、アクセス権を少しずつ獲得していきます。どの変更も、単体では重大に見えず、警戒すべきサインとして扱われにくいのです。各権限付与にはそれなりの理由と妥当性があります。

この段階的な拡張こそが、エージェントを見えにくくします。

責任は分断されます。AIエージェントを作ったチームが、今そのエージェントが触れているシステムのオーナーとは限りません。利用しているチームも、どのように認可されたのかを知らないことがあります。時間とともに、エージェントはワークフローの一部になりますが、インベントリの一部にはならないままです。

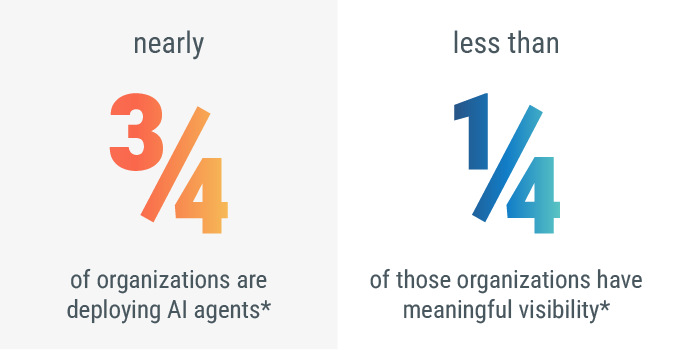

シャドーエージェントが広がるのは、組織がリスクを無視しているからではありません。スピード、自律性、分散化が、現代のチームの働き方にすでに組み込まれているからです。そして同じ近道が、1つの組織の中で何百回、場合によっては何千回も選ばれます。

*出典:The State of Agentic AI Security 2025

シャドーエージェントが既存のセキュリティ前提を崩す理由

多くのエンタープライズ向けセキュリティモデルは、2つの前提に基づいています。システムが把握できていること、そして権限付与が意図的に行われることです。

シャドーエージェントは、その両方に反します。

ユーザーとして現れません。従来のアプリケーションのようにも振る舞いません。セキュリティチームが長年かけて制御を構築してきたライフサイクルの型にも従いません。代わりに、その中間に存在します。スクリプトの一部であり、サービスの一部であり、自動化の一部でもあるような存在として、ファーストクラスのIDとして扱われないままアクセス権を蓄積します。

ここから前提が崩れ始めます。

セキュリティチームは通常、「このシステムのオーナーは誰か」「どのクレデンシャルを使うのか」「何が許可されているのか」といった問いに答えることに慣れています。しかしシャドーエージェントは、オーナーシップが分散し、権限が時間とともに継承され、ワークフローに合わせて挙動が静かに変化していくため、これらの問いをより難しくします。

結果として、明確なID、一貫したポリシー、膨らんでいく意図、信頼できる監督のないまま、実際の権限を持つ自律的なアクターが増えていきます。

これはツールの不足ではありません。モデルの不足です。

多くのセキュリティフレームワークは、人と予測可能に振る舞う機械を前提に作られてきました。シャドーエージェントは、そのどちらにも当てはまりません。独立して行動し、システム間をまたいで相互作用し、有用であるがゆえに存続します。正式に承認されたからではありません。

組織が自律的システムに対して、ID、ガバナンス、制御をどう適用するかを再考しない限り、シャドーエージェントは「許可されているもの」と「見えているもの」の間の領域で動き続けます。

なぜIDが破綻するのか

多くのセキュリティプログラムは、単純な前提に基づいています。「識別できるなら、制御できる」という前提です。

この前提は、クラウドサービス、API、自動化の中で人以外のIDが増え続けたことで、長年にわたり圧力を受けてきました。AIエージェントは、その前提を覆します。IDが増えるからではなく、自律性を持ち込むからです。

AIエージェントは、特に次の点でIDモデルを揺るがします。

- ファーストクラスのIDとして導入されない: エージェントは、スクリプト、インテグレーション、サードパーティツールから組み上げられることが多く、独自のクレデンシャルを発行されるのではなく、借用したクレデンシャルを使います。

- 権限が時間とともに蓄積される: 新しいタスクに適応させる過程で権限が段階的に追加されますが、アクセスの全体像を単一のオーナーがレビューすることは少なくありません。

- 挙動が進化する: 固定タスクを認証して実行するだけではありません。意思決定し、アクションを開始し、ワークフローの変化に合わせてシステム間での相互作用が変わります。

- 説明責任が曖昧になる: 共有ロールや継承されたクレデンシャルで動作すると、エージェントの挙動とシステムの挙動を切り分けにくくなり、アクションを明確なオーナーへ紐付けて追跡することが難しくなります。

AIエージェントのトラストは、もはや譲れない要件になった

AIエージェントの能力と普及が進むにつれて、自律性と監督のギャップは拡大していきます。これは組織が不注意だからではなく、この規模での意思決定の委任を前提に、既存のセキュリティモデルが作られていないためです。

短期的な変化は明確です。エージェントは「ツール」として扱われるのをやめ、「アクター」として扱われ始めます。つまり、あらゆるAIエージェントには、検証可能なID、明確なオーナーシップ、厳密に境界付けられた権限が必要になります。これは、本番システムの中で動作することが信頼される他のあらゆるエンティティと同じです。

この領域で先行できる組織は、1つの重要な変化を実行します。「エージェントが有用かどうか」ではなく、「認可されているかどうか」を問うようになるのです。

このシフトは、実務上の含意を伴います。AIエージェントは、事後に見つかるのではなく、デフォルトで発見可能でなければなりません。権限は偶発的に継承されるのではなく、意図的に付与される必要があります。そして、何かが起きたときに意味がある速度で、失効(クレデンシャルのローテーション、ポリシー適用、キルスイッチなど)を実行できなければなりません。

代替案は、より具体的です。

シャドーエージェントがID、ガバナンス、強制力なしに蓄積し続けると、インシデントは従来型の侵害のようには見えません。説明のつかないアクションとして現れます。発信源が不明なまま動くデータ、明確な起点がないまま変更されるシステム、人の関与なしに下される判断、そして追跡も停止もできない状態です。

エージェントのトラストがセキュリティの最重要課題にならない限り、組織はこの軌道を進み続けます。

エージェント型AIのセキュリティに本当に必要なこと

エージェント型AIのセキュリティは、ゼロからセキュリティを作り直すことを意味しません。ただし、長年のトラストモデルを、本来そこに収まるよう設計されていなかった対象へ拡張する必要があります。実務上は、AIエージェントを企業のトラストネットワークにおけるファーストクラスの参加者として扱うことを意味します。

少なくとも、組織は次の4つを実行できなければなりません。

- すべてのエージェントに検証可能なIDを付与する: 借用したクレデンシャルでつぎはぎされた匿名の抽象として、エージェントを放置することはできません。各エージェントには、行動の帰属、監査、強制をシステム横断で可能にする、固有で暗号的に検証可能なIDが必要です。

- 明確なオーナーシップと委任権限を確立する: すべてのエージェントには説明責任を負うオーナーと、明示的に定義された権限が必要です。権限は「付与しやすいから」ではなく、エージェントが本来行うべきことにスコープされ、エージェントの進化に合わせて見直されるべきです。

- エージェントをデフォルトで発見可能にする: エージェントをインベントリ化できない組織は、統制もできません。発見は手作業のドキュメント化や属人的知識に依存できず、エージェントの作成・デプロイの方法そのものに組み込まれている必要があります。

- ポリシーを強制し、アクセスを明確に失効できるようにする: エージェントが想定外の挙動をしたり侵害されたりした場合、組織は即時に介入できなければなりません。つまり、失効、ローテーション、停止の仕組みが、インシデントレビューの後ではなく、機械速度で機能する必要があります。

ここで「インテリジェントトラスト」が不可欠になります。

自律性が増すほど、トラストは静的でも暗黙でもいられません。ID、暗号、ポリシー、リアルタイムの強制を通じて、継続的に確立される必要があります。インテリジェントトラストは、デジタルトラストの進化であり、組織がエージェントのIDだけでなく、ある時点で「何が許可されているか」を検証し、状況の変化に応じてそのトラストを適応させることを可能にします。

デジサートとともに、エージェント型システムへトラストを組み込む

証明書、鍵、IDを機械規模で管理するだけでも十分に難しい課題です。そこに自律的エージェントが加われば、重要性はさらに高まります。ただし目標は、シャドーエージェントを完全に排除することではありません。光を当て、エージェント型システムを可視化し、統制可能にし、制御できる状態にすることです。自律性が手に負えない規模へ拡大しないようにするためです。

DigiCert ONEとTrust Lifecycle Managerは、ユーザー、マシン、デバイス、そしてAIエージェントに至るまで、暗号的IDを確立・管理できるよう企業を支援し、トラストを継続的で監査可能、かつ長期にわたりレジリエントなものにします。

この取り組みを始める組織にとって、次の一歩は「完璧さ」ではありません。「可視性」です。そこから、ID、ガバナンス、強制が続きます。シャドーエージェントが解きほぐせない存在になる前に。